Una ruptura entre Apple y el Whatsapp fue una de las principales noticias de la última semana. La nueva herramienta de “Apple” para identificar casos de abuso infantil en fotos generó polémica con el mensajero.

Lea mas: Consulta las novedades más esperadas de WhatsApp

vea mas

Alerta: ESTA planta venenosa llevó a un joven al hospital

Google desarrolla una herramienta de IA para ayudar a los periodistas en…

El anuncio de la función en el iPhone se realizó el jueves pasado (5). El objetivo es identificar imágenes que constituyan un delito de abuso/explotación infantil. Sin embargo, el representante de WhatsApp, Will Cathcart, dijo que la novedad violaría cuestiones legales. Además, también violaría la política de privacidad.

“Leí la información que Apple publicó ayer [08/05] y estoy preocupado. Creo que este enfoque es incorrecto y un revés para la privacidad de las personas en todo el mundo. La gente pregunta si vamos a adoptar este sistema para WhatsApp. La respuesta es no”, enfatizó Cathcart, en su cuenta de Twitter.

Will publicó varios mensajes para justificar sus preocupaciones sobre el anuncio de Apple. Según él, los gobiernos y las empresas de software espía podrían interceptar el software en el iPhone. Esto violaría la privacidad del usuario.

El ejecutivo también cuestiona la transparencia de Apple en el asunto. “¿Puede este software de escaneo en su teléfono ser infalible? A los investigadores no se les permitió averiguarlo. ¿Porque no? ¿Cómo sabremos con qué frecuencia los errores están violando la privacidad de las personas?

“Recibí confirmación independiente de varias personas de que Apple está lanzando una herramienta del lado del cliente para el análisis de CSAM. Esta es una muy mala idea. Estas herramientas permitirán a Apple escanear las fotos de tu iPhone en busca de imágenes que coincidan a un hash de percepción específico y reportarlos a los servidores de la compañía si aparecen demasiados", dijo. también.

Apple dijo que la información de escaneo de mensajes no es exactamente correcta. Los datos adquiridos del análisis de seguridad se colocarían en una base de datos cifrada. La empresa no estaría acumulando datos de las bibliotecas de fotos de los usuarios. Esto solo sucedería si se detectara material criminal.

Apple apuesta por la seguridad de los menores

Apple, por su parte, informó que la nueva característica es parte de un paquete de actualización programado para 2021. Este paquete es parte de una nueva política de protección al usuario lanzada por la empresa. El objetivo es identificar y prevenir a los niños y adolescentes de los depredadores sexuales.

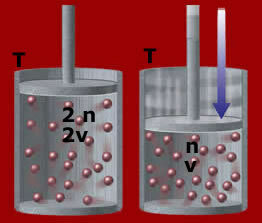

El nuevo sistema utiliza "NeuralHash", una especie de coincidencia neuronal. Así, sería capaz de detectar imágenes con huellas dactilares correspondientes a la pedofilia.

El problema con la novedad son los riesgos que puede traer a la seguridad de los datos del usuario. Expertos en la materia aseguran que podría generar vigilancia en mensajes encriptados. Esta es incluso la opinión de Matthew Green, del Instituto de Seguridad Johns Hopkins.

Según Apple, si bien existe la posibilidad de una lectura incorrecta, la tasa de usuarios con lectura incorrecta sería menos de uno en 1 billón por año.